Индексация – это процесс, при котором поисковые роботы обнаруживают, читают и добавляют ваши страницы в базу данных поисковой системы. Без нее сайт останется невидимкой для пользователей, даже если вы предлагаете самый крутой контент или продукт в мире.

Зачем нужна быстрая индексация сайта:

- Интернет-магазину — чтобы новая категория или товар поскорее начали привлекать покупателей. Быстрая индексация позволит опередить конкурентов и показать свои предложения целевой аудитории в числе первых.

- Информационному проекту — чтобы размещенный материал не потерял актуальность. Новостные сайты, блоги и СМИ должны оперативно выдавать свежий контент заинтересованным пользователям.

- Сайту услуг — чтобы тоже соревноваться с конкурентами в поиске. Чем раньше страницы проиндексируются, тем больше шансов захватить лидерские позиции в нише и привлечь новых клиентов.

В статье разберем, какие проблемы могут мешать быстрой индексации страниц, рассмотрим факторы, влияющие на этот процесс. И главное — дадим практические рекомендации, как ускорить индексацию сайта в Яндексе и Google.

- Сколько времени нужно для индексации страниц и что на это влияет

- Частые проблемы с индексацией сайта в поисковиках

- Способы ускорения индексации сайта

- Настройте robots.txt

- Создайте и обновляйте Sitemap.xml

- Устраните дубли на сайте

- Ускорьте загрузку страниц

- Проверьте структуру сайта

- Поработайте над внутренней перелинковкой страниц

- Проверьте мобильную адаптивность

- Обновляйте и добавляйте новый контент

- Добавьте сайт в каталоги и справочники

- Получайте обратные ссылки

- Отправьте страницы на переобход

- Где отслеживать индексацию страниц

- Кратко: основные способы ускорения индексации сайта

Сколько времени нужно для индексации страниц и что на это влияет

Процесс индексации новых или обновленных страниц может занимать от нескольких часов до нескольких недель. Точные сроки для каждого сайта назвать нельзя — они зависят от множества факторов и могут сильно варьироваться. Об этом говорил Джон Мюллер из Google в одном из видео #AskGooglebot.

Один их ключевых аспектов, влияющих на скорость индексации — качество контента. Страницы с полезным, уникальным и интересным для пользователей материалом будут индексироваться поисковыми системами гораздо быстрее.

Дело в том, что поисковики сталкиваются с огромным объемом информации в интернете и не могут проиндексировать абсолютно все. Поэтому роботы расставляют приоритеты и уделяют больше внимания сайтам с ценным контентом.

Но на скорость индексации также влияют и другие факторы:

- Техническое состояние сайта (скорость работы, отсутствие ошибок).

- Наличие внешних и внутренних ссылок на новые страницы.

- Корректная подача карты сайта и запросов на переобход.

Также Мюллер отмечал, что быстрая индексация еще не гарантирует высокое ранжирование. Страницы должны не только быстро находиться роботами, но и соответствовать многим другим критериям ранжирования.

Читайте также: Факторы ранжирования Google в 2024: Анализ Semrush

Частые проблемы с индексацией сайта в поисковиках

Глобально можно выделить 3 проблемы:

Страницы вообще не индексируются. В чем могут быть причины:

- Неправильно настроенный файл robots.txt. Если в файле прописаны неправильные инструкции, это может привести к блокировке индексации всего сайта или его отдельных частей.

- Запрет индексации в метатегах или HTTP-заголовках. Метатег robots или HTTP-заголовки могут содержать директивы, запрещающие индексацию страниц, например noindex. Если такие директивы установлены, поисковые системы не будут индексировать соответствующие страницы.

- Проблемы с доступностью страниц. Если сервер недоступен, перегружен или настроен неправильно, поисковые системы не смогут получить доступ к страницам сайта для их индексации. Также проблемой может быть некорректный код ответа сервера, например, ошибка 5xx.

Страницы не индексируются в одной из поисковых систем. В чем могут быть причины:

- Фильтры и санкции. Если сайт нарушает правила поисковых системам, он может попасть под временные или постоянные фильтры (санкции), что приведет к исключению из индекса или понижению позиций в результатах поиска.

- Разные политики индексации. Google и Яндекс используют разные алгоритмы и подходы к индексации. Это может привести к ситуации, когда сайт хорошо индексируется одной поисковой системой и плохо другой.

- Техническая несовместимость. Некоторые сайты используют технологии, которые плохо поддерживаются или воспринимаются поисковыми системами. Например, если сайт полностью построен на JavaScript, и поисковый бот не может корректно обрабатывать JS, это может стать причиной проблем с индексацией.

Страницы индексируются, но очень долго. В чем могут быть причины:

- Редкое обновление и добавление нового контента. ПС отдают приоритет сайтам с регулярно обновляемым контентом, так как это сигнал об актуальности и полезности ресурса для пользователей. Если на вашем сайте редко появляются новые материалы, то поисковые боты могут реже его посещать и медленнее индексировать страницы.

- Плохая внутренняя перелинковка и структура сайта. Грамотная внутренняя перелинковка страниц создает четкую иерархию разделов и облегчает сканирование для роботов. Если новые или важные разделы слабо интегрированы в структуру, боты могут их пропускать или долго не замечать. Нелогичная навигация также затрудняет индексацию.

- Некачественная оптимизация контента. Поисковики лучше индексируют контент с правильным распределением ключевых слов, метатегами, структурированием. Некачественная оптимизация или переспам ключами может восприниматься как сигнал низкой ценности страниц.

- Низкая скорость загрузки и производительность. Медленно работающие сайты замедляют сканирование роботами. Поисковики могут пропускать такие ресурсы, чтобы не создавать излишнюю нагрузку. Оптимизация производительности критически важна.

- Недостаточная ссылочная масса и авторитет. Наличие естественных ссылок с внешних ресурсов сигнализирует о популярности и ценности сайта. Низкая ссылочная масса, особенно на новых проектах, замедляет процесс индексации.

Читайте по теме: Почему не индексируется сайт: 5 основных причин невидимости вашего сайта для Google и Яндекса

О том, как решить эти проблемы, поговорим далее.

Способы ускорения индексации сайта

Чтобы новые страницы быстрее попадали в индекс, нужно комплексно работать над качеством контента, технической оптимизацией, ссылочной массой и другими параметрами сайта. Разберем их подробнее:

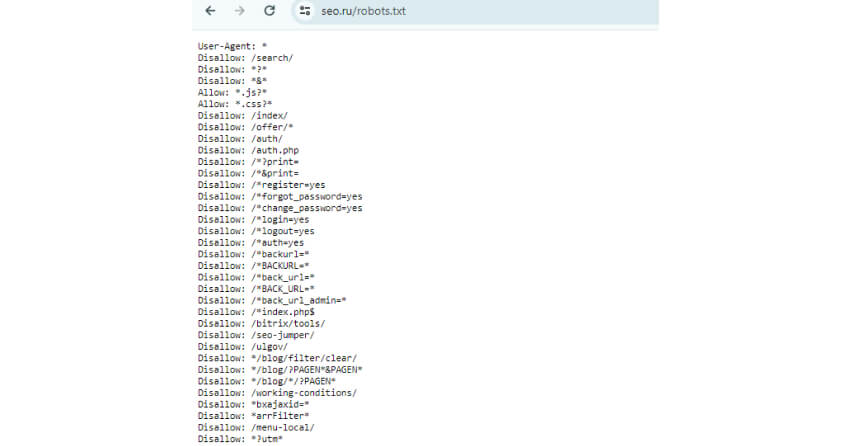

Настройте robots.txt

Файл robots.txt указывает поисковым ботам, какие страницы разрешено индексировать, а какие — нет.

Чтобы проверить разрешения в robots.txt:

- Откройте файл robots.txt и изучите указанные в нем директивы allow и disallow. Они определяют, какие разделы и страницы сайта доступны или закрыты для сканирования роботами.

Пример robots.txt:

Убедитесь, что доступ открыт ко всем важным общедоступным страницам. В то же время блокировка может быть полезна для:

- Страниц поиска, фильтров, корзины.

- Служебных технических страниц.

- Разделов, дублирующих контент.

- Страниц в разработке.

- В файле можно задать правила для каждого поискового робота отдельно (Googlebot, Яндекс бот). Это позволяет более гибко управлять индексацией.

- Применяйте регулярные выражения и условия путей для задания более точных правил. Например: disallow: /*?

- Чтобы предотвратить дублирование контента, укажите главное зеркало (host) вашего сайта.

- Расположите robots.txt в корневой директории сайта, чтобы он был доступен по адресу site.ru/robots.txt.

Верно настроенный файл robots.txt позволит роботам быстрее добраться к нужным разделам и избежать индексации ненужных страниц. Это ускорит обработку сайта и улучшит индексацию основного контента.

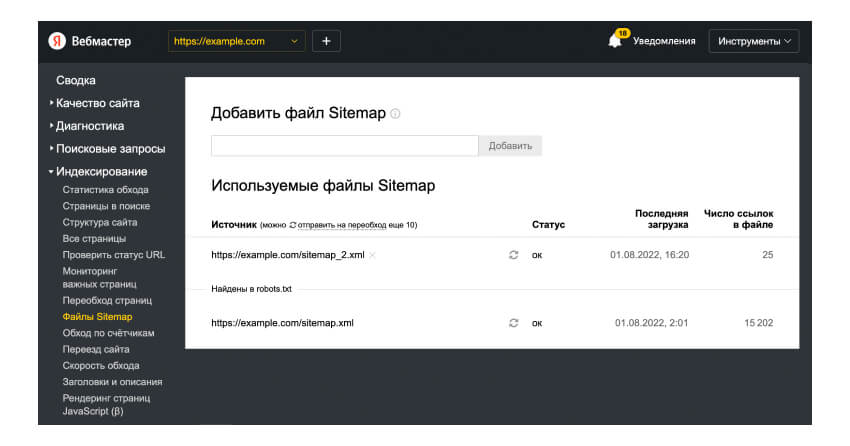

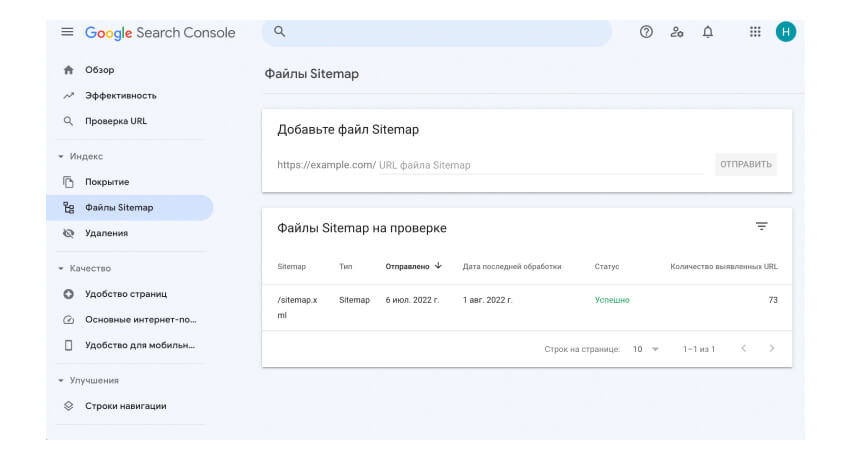

Создайте и обновляйте Sitemap.xml

Карта сайта в формате XML — специальный файл, который содержит список всех важных URLs сайта с дополнительными метаданными. Его основная цель — облегчить сканирование и индексацию страниц поисковыми роботами.

Создание Sitemap.xml:

- Cгенерировать sitemap можно вручную, соблюдая стандарты протокола Sitemaps. Или использовать онлайн-сервисы и плагины CMS, которые автоматически формируют файл.

- Готовый Sitemap.xml размещают в корневой директории сайта, например: https://mysite.ru/sitemap.xml

Обновление Sitemap:

- С добавлением новых страниц и изменением контента Sitemap нужно обновлять. Для этого используйте тег <lastmod> для указания даты последнего обновления страницы.

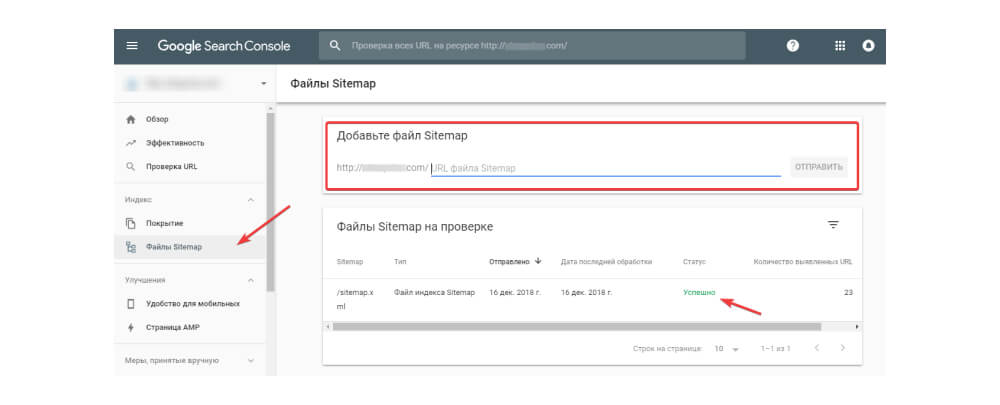

- После обновлений отправьте новый файл в Google Search Console и Яндекс.Вебмастер через специальные формы.

В Вебмастере:

В GSC:

- Проверяйте работоспособность Sitemaps через валидаторы в вебмастерских системах.

Устраните дубли на сайте

Если на сайте есть одинаковый или очень похожий контент на разных страницах, поисковым системам трудно понять, какая из этих страниц основная и наиболее релевантная. Им сложнее правильно оценить и расположить такие дублированные страницы в поисковой выдаче.

Дубликаты могут быть явными и неявными.

К явным относятся:

- Одна и та же страница, доступная по разным URL (с www и без, со слэшем на конце и без, по http и https).

- Страницы с дублирующимся контентом из-за URL с GET-параметрами.

Неявные дубли часто возникают из-за особенностей структуры и контента сайта:

- Страницы с комментариями генерируют уникальные URL, но основной контент продублирован.

- Продуктовые страницы со схожими описаниями товаров.

- Пагинированные разделы, где контент распределен по нескольким URL.

Чтобы избавиться от дублей, нужно:

- Настроить 301 редирект с дублирующих URL на каноническую версию. Это позволит сохранить ссылочный вес и передать его основной странице.

- Использовать тег rel="canonical" для указания поисковикам предпочтительной версии страницы из нескольких дублей.

- Для неявных дублей стремиться к созданию уникальных описаний продуктов, страниц. Для пагинированного контента применять rel="next/prev" или прописывать каноническую ссылку на основную страницу раздела.

- Если это невозможно, задействовать директивы файла robots.txt для запрета индексации дублирующихся разделов.

Устранение дублей позволит поисковикам лучше распознавать релевантный контент и сосредоточиться на индексации уникальных страниц. Это положительно скажется на скорости обхода сайта и качестве индексации.

Ускорьте загрузку страниц

Чем быстрее страница загружается, тем легче боту ее проиндексировать. В идеале скорость загрузки страницы должна быть не дольше 3 секунд. Для этого нужно оптимизировать размер изображений и других медиафайлов, использовать кэширование, минификацию CSS/JS, отложенную загрузку контента.

Медленная скорость загрузки — одна из главных проблем, которая затрудняет работу поисковых ботов по сканированию и обработке контента сайта.

Дело в том, что роботы очень чувствительны к производительности сайта. Если страницы грузятся дольше 3 секунд, поисковики могут просто пропустить их или вовсе прекратить обход из-за высокой нагрузки.

Представитель Google Джон Мюллер заявлял, что если среднее время ответа сервера превышает 1 секунду, то Googlebot снизит интенсивность сканирования, чтобы не перегружать ресурсы.

Как ускорить загрузку страниц сайта:

- Используйте сжатие изображений, уменьшайте размер файлов без потери качества, например, через формат WebP.

- Минифицируйте CSS, JavaScript, HTML Удалите комментарии, пробелы и другие избыточные данные в файлах стилей, скриптов и разметки. Это уменьшит их размер.

- Настройте кэширование статических файлов на стороне сервера и браузера.

- Размещайте файлы на CDN (сети доставки контента), чтобы ускорить их загрузку для удаленных пользователей.

- Оптимизируйте HTML/CSS/JS. Сжимайте код, удаляйте неиспользуемые стили, скрипты. Объединяйте JS/CSS файлы для уменьшения числа запросов.

Читайте по теме: Как увеличить скорость загрузки сайта. Рекомендации по улучшению показателя INP

Проверьте структуру сайта

Правильная структура сайта помогает поисковым роботам легче обнаруживать и сканировать ваши страницы. Она должна быть логичной, иерархичной и без «оторванных» разделов.

Нужно избегать так называемых «страниц-сирот» — это страницы, на которые не ведут внутренние ссылки с других разделов сайта. Роботам сложно их найти и определить релевантность.

Каждая страница должна быть интегрирована в общую структуру и иметь ссылки как минимум из родительской категории. Оптимальным считается размещение взаимных ссылок между смежными разделами и страницами.

Также стоит учитывать click depth или количество кликов от главной до нужной страницы. Чем меньше это значение, тем выше «ранг» страницы с точки зрения поисковиков. Желательно, чтобы приоритетные разделы и страницы находились в 2-3 кликах от главной.

Поработайте над внутренней перелинковкой страниц

Грамотная внутренняя перелинковка облегчает распространение ссылочного «веса» между страницами и помогает роботам быстрее их обнаруживать.

Рекомендуется:

- Создавать ссылки из текстового контента с ключевыми словами в анкорах.

- Использовать ссылочную навигацию в меню.

- Размещать обязательные ссылки на главную, важные разделы на всех страницах.

- Регулярно проверять и исправлять неработающие ссылки.

Правильная оптимизация структуры и перелинковки позволит поисковикам быстро сканировать и индексировать даже большие сайты с множеством страниц. Это критически важно для эффективного поискового продвижения.

Проверьте мобильную адаптивность

Мобильный трафик продолжает расти, поэтому поисковые системы при индексации отдают приоритет сайтам с адаптивным дизайном.

С ростом мобильного трафика поисковые системы стали уделять особое внимание тому, насколько хорошо сайты оптимизированы для смартфонов и планшетов. При прочих равных условиях преимущество в индексации отдается ресурсам с адаптивным, отзывчивым дизайном перед неадаптивными.

Чтобы не допустить сбоев в индексации из-за проблем с мобильной версией, необходимо принять одно из следующих решений:

- Использовать респонсив или адаптивную верстку, которая автоматически подстраивает контент под различные размеры экранов.

- Создать отдельную мобильную версию сайта с облегченным дизайном и функционалом.

Далее стоит протестировать корректность отображения и скорость загрузки мобильной версии с помощью инструментов Lighthouse и Проверка мобильных страниц в Яндекс.Вебмастере.

Если сайт адаптивен для мобильных пользователей, его релевантность в глазах поисковых систем повышается, индексация может проходить быстрее.

Читайте по теме: Mobile first: 7 шагов по оптимизации сайта под мобильные устройства

Обновляйте и добавляйте новый контент

Регулярное обновление показывает поисковикам, что ресурс активно поддерживается. Оптимально обновлять контент 1-2 раза в неделю.

Экспериментируйте с различными форматами — тексты, видео, изображения, интерактивный контент. Это поможет удержать внимание пользователей и повысить индексацию страниц.

Используйте HTTP-заголовки Last-Modified и If-Modified-Since, чтобы поисковики обновляли только измененные страницы.

Добавьте сайт в каталоги и справочники

Регистрация бизнеса в сервисах Google Мой Бизнес, Яндекс.Бизнес, 2ГИС ускоряет индексацию и помогает улучшить локальную выдачу. В них нужно внести достоверные данные о компании, добавить описание деятельности, контакты, фотографии и другие сведения. Такие бизнес-листинги подтверждают существование организации и помогают поисковикам быстрее найти и проиндексировать связанный с ней сайт.

Получайте обратные ссылки

Обратные ссылки с авторитетных и тематических ресурсов являются одним из ключевых факторов ранжирования в поисковых системах. Они также играют важную роль в ускорении индексации сайта.

Чем больше качественных ссылок ведет на ваш сайт, тем быстрее поисковые боты его заметят и проиндексируют. Сосредоточьтесь на получении ссылок с релевантных сайтов вашей тематики, новостных порталов, блогов лидеров мнений, форумов.

Читайте по теме: Как получить обратные ссылки на сайт: бесплатные и платные способы

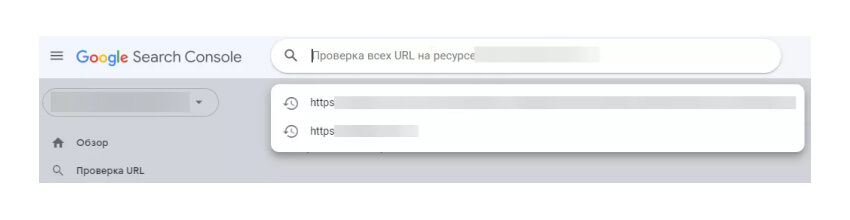

Отправьте страницы на переобход

Вебмастерские инструменты Google Search Console и Яндекс.Вебмастер позволяют уведомлять поисковые системы об изменениях на сайте. С их помощью вы можете отправлять запросы на принудительную индексацию новых, измененных или важных страниц в ручном или автоматическом режиме.

В Google Search Console есть два основных способа запросить повторное сканирование и индексацию страниц сайта:

Инструмент проверки URL. Этот инструмент позволяет отправлять отдельные URL на повторное сканирование поисковым ботом Google. Для этого:

- Перейдите в раздел «Проверка URL» в меню Search Console.

- Вставьте URL интересующей страницы и нажмите «Проверить URL».

- Система проверит статус индексации этой страницы.

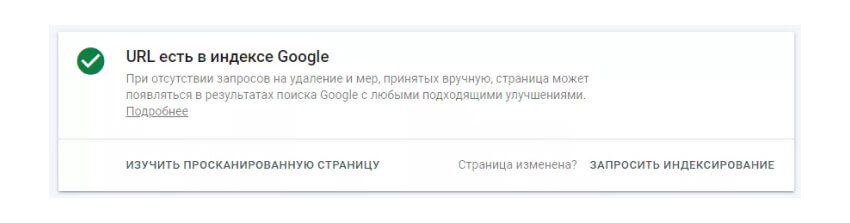

Так выглядит статус, если URL есть в индексе:

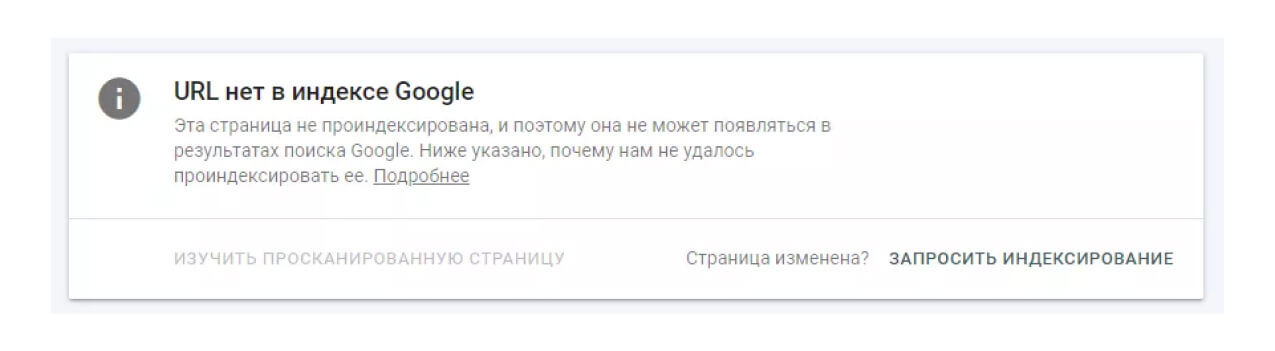

А так, если нет:

- Если страница уже была просканирована, внизу будет кнопка «Запросить индексирование».

- Перейдите в раздел «Проверка URL» в меню Search Console.

Но нужно учитывать, что на этот инструмент установлены ограничения — до 500 запросов в сутки. Также он не гарантирует немедленную индексацию.

Файл Sitemap. Более подходящий способ для запроса сканирования большого числа страниц — отправка файла Sitemap в Search Console. Он содержит список всех URL на вашем сайте.

- Сгенерируйте файл Sitemap.

- Перейдите в раздел «Sitemap» в меню Search Console.

- Отправьте файл Sitemap туда через опцию «Добавить sitemap».

После этого Google начнет сканировать и обрабатывать все URL из файла для индексации.

В любом случае, запрос пересканирования не гарантирует индексацию. Контент должен быть качественным и соответствовать принципам поисковика.

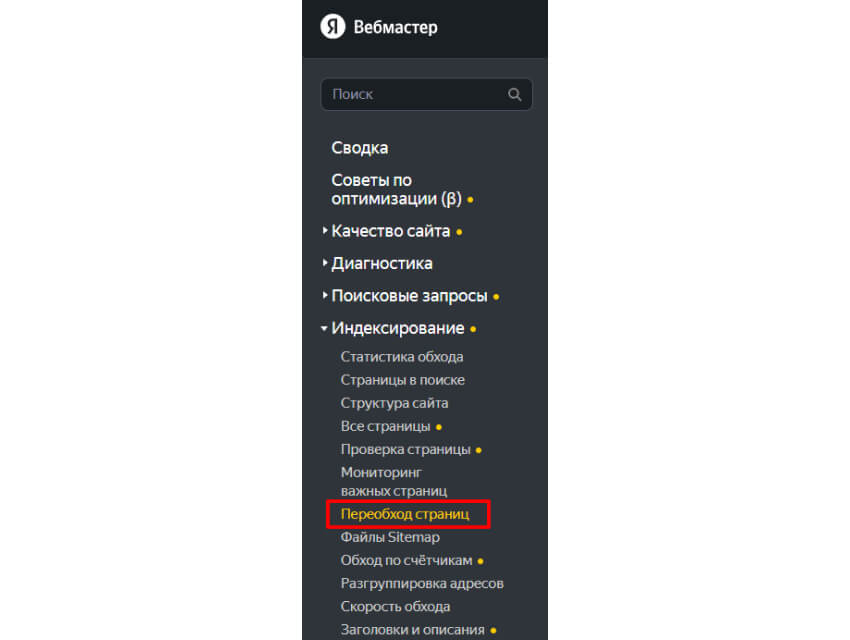

Как запросить переиндексирование страниц в Яндекс.Вебмастер:

- Зайдите в раздел «Индексирование» → «Переобход страниц».

- Вставьте ссылку и нажмите «Отправить».

- Можно отправлять до 20000 URL в сутки.

Кроме ручного варианта, Яндекс позволяет массовую отправку через файл со списком ссылок или специальные HTTP-заголовки.

В обоих сервисах есть ограничения по количеству ссылок в день. Также важно не злоупотреблять этой функцией без необходимости, чтобы не создавать излишнюю нагрузку на поисковые системы.

Где отслеживать индексацию страниц

Есть несколько способов:

- Google Search Console и Яндекс.Вебмастер

В этих инструментах доступна детальная статистика о количестве проиндексированных страниц, выявленных ошибках и многом другом.

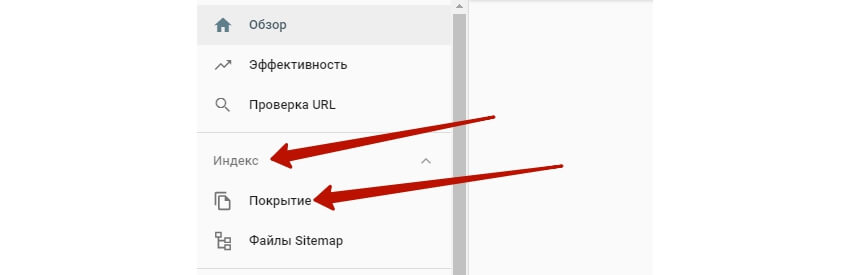

В Google Search Console перейдите в раздел «Индекс» → «Покрытие». Здесь вы увидите статистику проиндексированных, заблокированных и исключенных страниц, а также графики последних изменений в индексе.

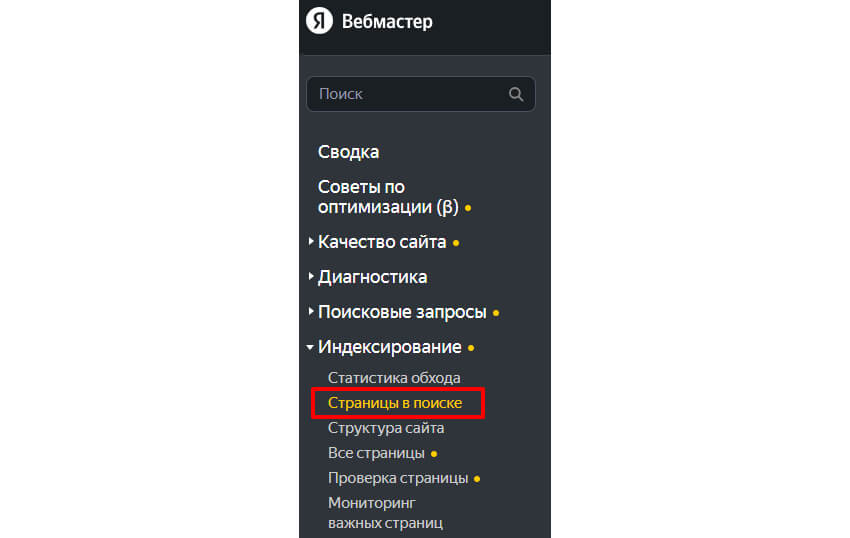

В Яндекс.Вебмастере зайдите в раздел «Индексирование» → «Страницы в поиске». Вы сможете отслеживать количество страниц в индексе Яндекса и историю их добавления/удаления.

Если графики не обновляются долгое время — это признак проблем с индексацией.

- SEO-сервисы

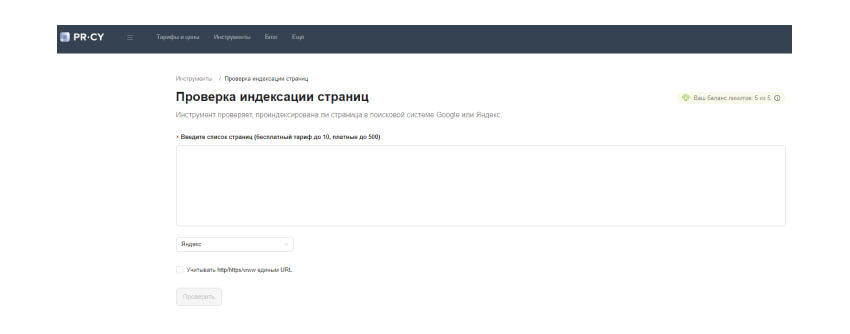

Специализированные SEO-платформы, например, Топвизор, PR-CY, Ahrefs, собирают данные об индексации из поисковых систем.

В них вы найдете графики динамики индексации по дням, информацию об исключенных из индекса страницах, ошибках и прочие аналитические отчеты.

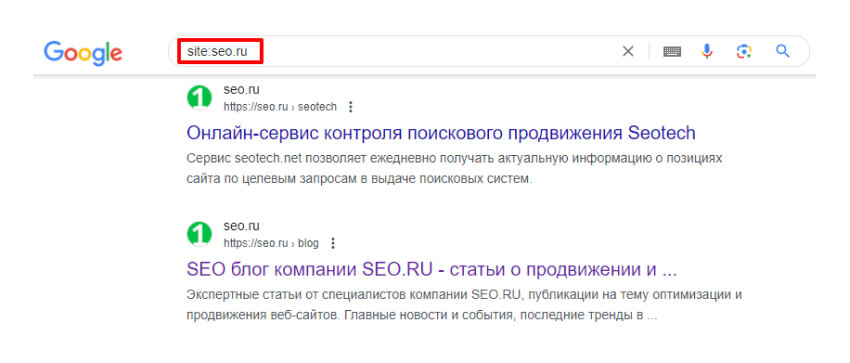

- Ручная проверка индексации через оператор «site:»

Поисковая команда site:url_страницы позволяет проверить нахождение конкретных страниц в индексе. Если страница присутствует, она отобразится в выдаче.

Регулярный мониторинг по этим методам позволит вовремя заметить проблемы и принять соответствующие меры.

Кратко: основные способы ускорения индексации сайта

- Настройте robots.txt для доступа ботов ко всем нужным страницам.

- Создайте Sitemap.xml и регулярно обновляйте его после изменений.

- Устраните дубли контента на сайте с помощью 301 редиректа, rel=canonical, фильтрации robots.txt.

- Оптимизируйте скорость загрузки страниц — сжатие, кэширование, CDN и т.д.

- Проверьте логичность структуры сайта, разделите контент по категориям.

- Наладьте внутреннюю перелинковку между релевантными страницами.

- Обеспечьте адаптивность дизайна под мобильные устройства.

- Регулярно публикуйте новый уникальный контент, обновляйте старый.

- Зарегистрируйте сайт в тематических каталогах и справочниках.

- Работайте над получением качественных обратных ссылок.

- Отправляйте новые/обновленные страницы на сканирование через Search Console и Вебмастер.

Помните, что ни один отдельный фактор не гарантирует 100% индексацию. Но ускорить ее возможно. Для этого нужен комплексный подход — оптимизация технической составляющей, внутренних и внешних факторов.

И еще: индексация — это не одноразовый процесс. Требуется постоянная работа — регулярный аудит, устранение ошибок, публикация нового контента, получение новых ссылок и упоминаний.

Если вы хотите, чтобы ваш сайт быстрее появлялся в поисковых системах — обращайтесь в SEO.RU. Мы проведем всесторонний аудит вашего ресурса и найдем, что мешает его быстрой индексации. Затем составим план, как улучшить ваш сайт, чтобы он соответствовал требованиям Яндекса и Google. Поработаем над вашим контентом и ссылочной массой, чтобы сайт быстрее индексировался и вышел в ТОП выдачи.

Подписывайтесь на наш Телеграм-канал. Там мы постим новости SEO-сферы, обновления Яндекса и Google, статьи про продвижение сайтов и дайджесты.

![Вопрос-ответ от службы поддержки Google SEO + комментарии эксперта SEO.RU [август 2023]](/upload/iblock/314/31435e8d1863eda51247550521707a95.jpg)