Автор: Максим Улендеев — SEO-специалист SEO.RU

В последнее время SEO-специалисты часто сталкиваются с ситуацией, когда отчеты Метрики показывают всплеск неестественного трафика. Это могут быть переходы из поисковых систем или прямые заходы на сайт (по прямой ссылке) с большим процентом отказов по этим источникам.

Такое происходит из-за преднамеренных действий ботов, которые влияют на различные поведенческие факторы (ПФ) сайта — глубину просмотра, долю отказов, время нахождения на ресурсе и т.д. В результате поисковые системы могут счесть такой рост ПФ неестественным и понизить позиции сайта в выдаче.

Как обнаружить накрутку поведенческих факторов, можно ли с этим бороться и какими способами — об этом расскажем в статье. В конце приведем реальный кейс, как мы боролись с ботами и отрицательной накруткой ПФ на сайте нашего клиента.

- Что такое накрутка поведенческих факторов

- Какие бывают накрутки

- Как выявить ботов

- Последствия накрутки

- Что делать, если вам накручивают ПФ

- Чего не стоит делать

- Кейс SEO.RU: как мы спасли сайт от накрутки ПФ

- Коротко: как можно бороться с накруткой ПФ ботами

Что такое накрутка поведенческих факторов

Если посетители часто заходят на сайт, просматривают страницы, оставляют заявки, переходят по внутренним ссылкам — это говорит о хороших поведенческих факторах сайта. Такие показатели положительно влияют на ранжирование в поисковых системах, особенно в Яндексе.

Некоторые оптимизаторы предлагают услуги по улучшению позиций за счет накрутки поведенческих факторов. Чаще всего накрутку используют, чтобы быстро поднять новый сайт, не вкладываясь в «белые» методы SEO.

Еще одна цель — навредить конкурентам, создав на их ресурсах искусственный трафик с короткими сессиями, имитируя отказы. Обычно это делается через боты и в итоге ухудшает позиции сайта-мишени.

Вообще любые попытки искусственно повлиять на ранжирование нарушают правила поисковиков. Если обнаружится накрутка, сайт может быть понижен или вовсе исключен из выдачи.

Так, Яндекс пишет, что за использование имитации действий пользователей срок действия ограничений составляет 8—12 месяцев. Чтобы снять ограничения с сайта, скорее всего, придется решать вопрос со службой поддержки.

Читайте по теме: Как улучшать поведенческие факторы сайта без страха и упрека

Какие бывают накрутки

Накрутки делятся на два вида: нативные и RPA:

Нативная (человеческая) накрутка. Для нее нанимаются реальные люди, которым выдается конкретное задание — ввести ключевое слово, кликнуть определенные сайты в выдаче, зайти на целевой ресурс, пролистать его до заданной страницы, провести там некоторое время и т.д.

RPA-накрутка. Выполняется специальными программами-роботами по заранее заданному алгоритму. Такая накрутка дешевле и быстрее, но часто определяется поисковиками как неестественная активность.

Пользоваться простыми ботами для накрутки поведенческих факторов нельзя. Это не работает, если у пользователя нет истории браузера и он нигде кроме целевого сайта не появлялся. Поэтому накрутчики перешли к другой тактике: они создают ботов, «прогуливаются» ими пару недель по куче сайтов, имитируя некую пользовательскую активность, а потом идут в выдачу по целевому сайту. Цель тут именно в том, чтоб показать поиску, что этот пользователь — не новый бот.

Накрутчики воздействуют на следующие поведенческие факторы:

- Кликабельность (CTR) — насколько часто пользователи переходят на сайт с выдачи и не возвращаются.

- Глубина просмотра — число просмотренных страниц за сессию.

- Доля дочитывания страницы до конца.

- Время нахождения на сайте — чем дольше, тем лучше.

- Показатель отказов — когда посетители проводят на странице не больше 15 секунд.

- Полезность ресурса — прямые переходы, из соцсетей, возвраты (добавление в закладки и т.д.).

При массовой атаке ботов в лучшем случае испортятся показатели в метрике, не отразившись на реальной посещаемости. В худшем — сайт может быть понижен в выдаче на срок до 12 месяцев за накрутку.

Читайте по теме: Как оценить и улучшить поведенческие факторы на своем сайте: чек-лист

Как выявить ботов

Выявить накрутку можно по данным в Яндекс.Метрике и Вебмастере.

Признаки накрутки:

- Резкий рост трафика и количества пользователей.

- Большое число прямых заходов на сайт, тогда как раньше доминировал трафик из поиска.

- Возможен высокий показатель роботности в аналитике (не всегда).

- Уменьшение времени нахождения на сайте.

- Рост доли отказов. Отказы поисковые системы считают по-разному. Для Яндекса отказ — это когда посетители проводят на странице менее 15 секунд и покидают ее. Отказ для Google — это сеанc, за время которого пользователь совершил единственное событие — просмотрел одну страницу на сайте.

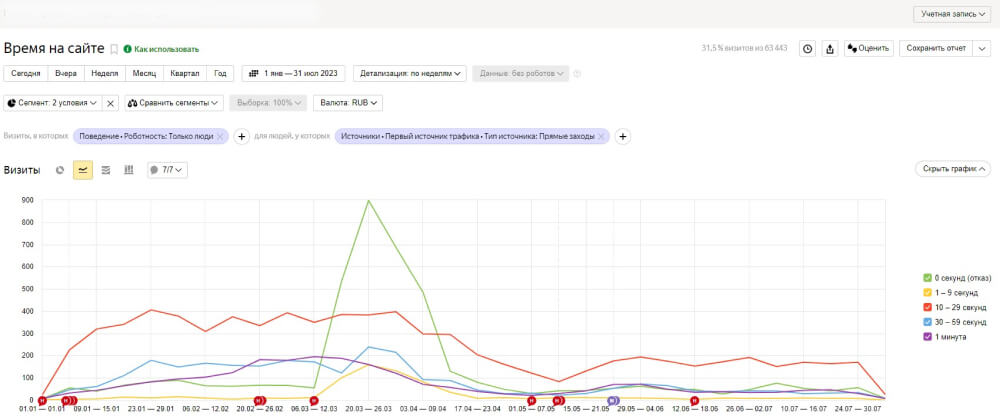

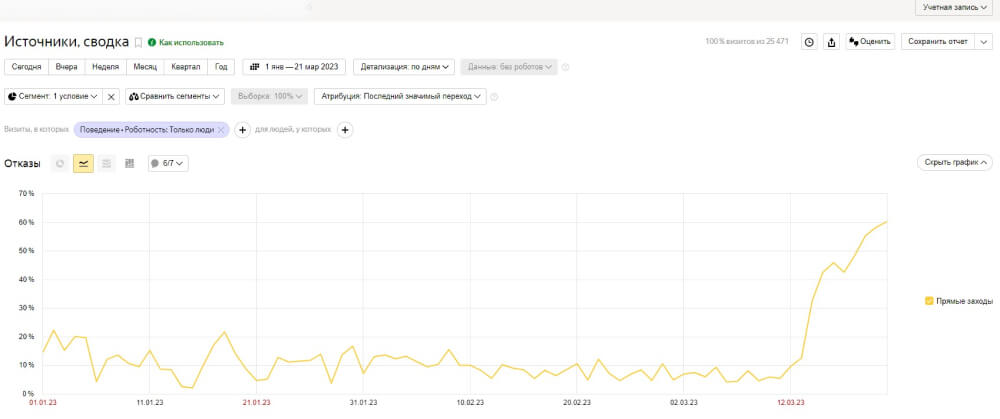

На скрине ниже указан график из Метрики с резким всплеском показателя «Отказы» (зеленая линия) по прямым заходам на сайт.

Последствия накрутки

Узнать о накрутке можно по резкому скачку трафика в метрике и отчетах Вебмастера за неделю. Это первый сигнал, что произошла искусственная манипуляция посещаемостью.

Последствия трудно предсказать заранее. Обычно сайт начинает раз за разом терять позиции в выдаче поисковых систем. Спустя время переместится на нижние строчки в ранжировании, где тяжелее бороться за трафик.

Сайт может потерять десятки позиций в течение месяца и переместиться с первой страницы выдачи на 3-4 страницу и ниже. Такое положение сильно снижает поток трафика из поиска.

Восстановление былых позиций займет от нескольких недель до нескольких месяцев в зависимости от глубины падения. Чем серьезнее была накрутка, тем сложнее реабилитировать сайт.

Если сайт упал несильно, на 2-3 позиции, его можно относительно быстро вернуть в топ выдачи качественным контентом и оптимизацией.

Таким образом, накрутка почти всегда наносит ощутимый вред сайту.

Что делать, если вам накручивают ПФ

Чтобы бороться с накруткой, можно использовать такие методы:

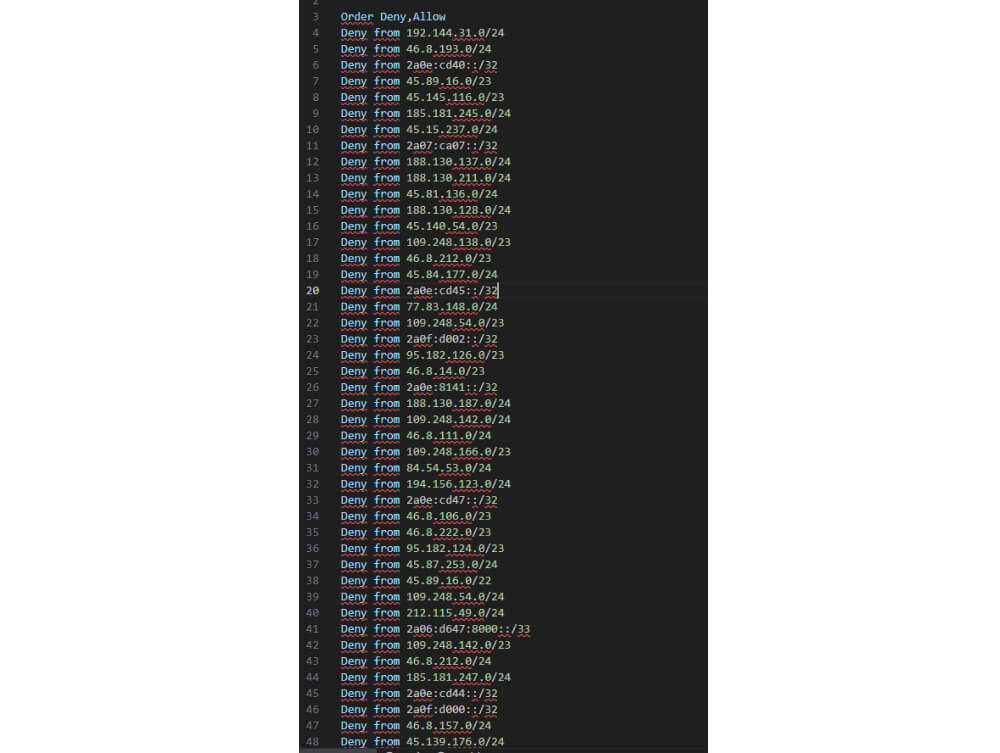

1. Блокировка IP-адресов откуда идут атаки ботнетов

Суть этого метода в том, чтобы заблокировать подозрительные IP адреса, с которых идет атака ботов на сайт. IP-адреса, которые ведут себя подозрительно, заносятся в черный список или блокируются через брандмауэр.

Как это работает:

- Анализируются логи веб-сервера и выявляются IP адреса, с которых за короткое время приходит аномально большое количество запросов.

- Эти подозрительные IP прописываются в файле директивы (командами).

- Для этих IP применяются правила блокировки на уровне firewall.

- Все новые запросы с заблокированных IP будут отбрасываться на уровне firewall (брандмауэра).

Перед применением такого решения нужно провести аналитику и тщательно проверить логи сервера.

Плюсы:

- Простота реализации такой блокировки на уровне firewall.

- Эффективно останавливает атаки с конкретных IP.

- Хорошо работает для таргетированных атак с фиксированных IP.

Минусы:

- Может блокировать легитимных пользователей с зараженных ботнетом IP.

- Боты могут легко сменить IP, используя прокси и анонимайзеры. Неэффективно при распределенных атаках с разных IP.

- Требует постоянного мониторинга трафика и обновления черных списков.

Этот метод позволяет заблокировать сразу большой диапазон подозрительных IP-адресов, используемых для атак ботнетов. Но требует тщательного анализа трафика перед применением.

2. Установка антибот-скриптов

Такие скрипты за секунды определяют настоящих посетителей и пропускают их на сайт. Боты блокируются и не могут попасть на ресурс.

Как это работает:

- На сайт устанавливается JavaScript код, который анализирует поведение пользователей.

- Проверяется выполнение JavaScript, время на странице, движение мыши, нажатия клавиш.

- На основе эвристики определяется — человек это или бот.

- Боты блокируются, люди пропускаются дальше.

Плюсы:

- Эффективно отличает ботов, которые не выполняют скрипты.

- Быстрая загрузка для реальных пользователей.

- Простая интеграция в сайт, модульный подход.

- Может обнаружить изощренных ботов по поведению.

- Нет необходимости постоянно обновлять списки ботов.

Минусы:

- Сильный фильтр будет платным.

- Несовместимость со скриптами кэширования страниц.

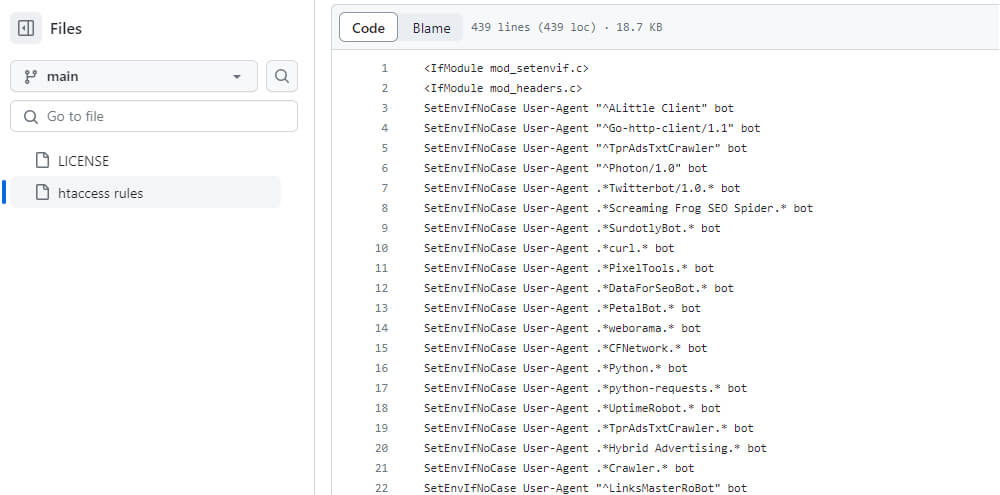

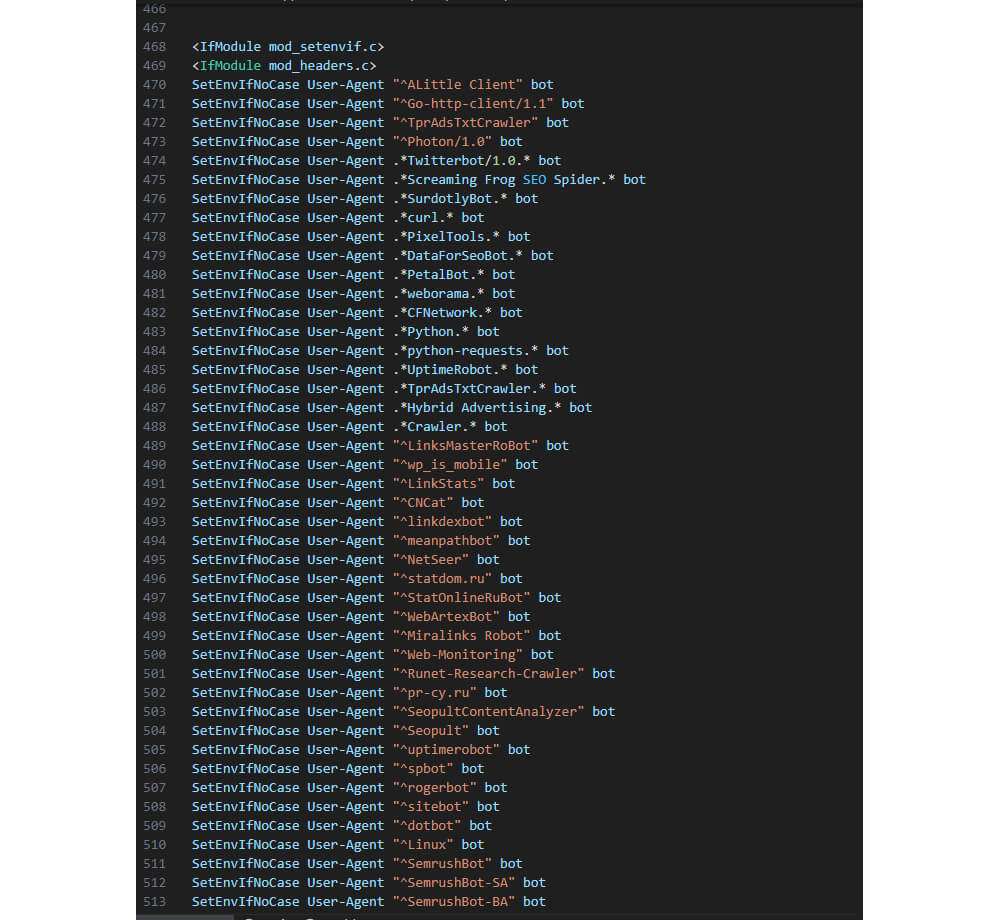

3. Блокировка User Agent сервисов по сканированию сайтов

.htaccess — это конфигурационный файл сервера Apache, который позволяет управлять настройками на уровне каталогов и веб-приложений.

Как это работает:

- В .htaccess файл добавляются правила (RewriteRules), которые перенаправляют запросы от определенных user agent к файлу-заглушке или странице блокировки.

- Можно использовать регулярные выражения для выявления типичных user agent ботов и скриптов.

- Также в правилах указывается код ответа 403 или 404 для заблокированных ботов.

Плюсы:

- Простота настройки, не требуется изменять основной код сайта.

- Возможность гибкой фильтрации по User Agent.

- Хорошо подходит для блокировки обычных сканеров и скриптов.

Минусы:

- Работает только на серверах Apache с поддержкой .htaccess.

- Боты могут обойти User Agent.

- Правила нужно правильно настроить, чтобы не заблокировать реальных пользователей.

- Не подходит для защиты от изощренных ботов.

В целом, это полезный инструмент для базовой защиты от простых ботов, но требует аккуратной настройки и должен использоваться в сочетании с другими методами защиты.

4. Использование Cloudflare

Cloudflare — это сервис, который помогает ускорить работу сайтов и защитить от DDoS атак. Позволяет блокировать спам-ботов.

Как это работает:

- Сайт пропускается через proxy сервера Cloudflare при помощи изменения DNS записей.

- Весь трафик на сайт проходит через инфраструктуру Cloudflare.

- С помощью механизмов machine learning Cloudflare анализирует трафик и выявляет ботов и атаки.

- Боты и злонамеренные запросы блокируются на уровне proxy Cloudflare еще до того, как попасть на сервер сайта.

- Легитимный трафик проходит на сайт. Также возможно кеширование контента.

- При атаках автоматически включаются механизмы защиты от DDoS.

- В настройках можно вручную заблокировать подозрительные IP адреса.

- Есть возможность интеграции с дополнительными сервисами безопасности.

Плюсы:

- Улучшенная защита от DDoS атак и вредоносного трафика.

- Ускорение загрузки сайта за счёт кеширования и оптимизации.

- Бесплатные SSL сертификаты и поддержка HTTPS.

- Надежная и распределенная сеть DNS серверов.

- Есть бесплатный базовый тариф.

Минусы:

- Может вносить задержки при загрузке контента из кэша.

- Чтобы получить больше функций, нужно платить. Тарифы начинаются от $25 в месяц.

5. Перенос сайта на новый домен с переклейкой 301 редиректом

Такой способ позволит перенаправить посетителей и поисковых роботов на новый адрес, минуя просевший сайт.

Как это работает:

- Регистрируется новый домен для сайта.

- Контент и файлы сайта переносятся на новый домен.

- На старом домене настраивается перенаправление 301 (permanent redirect) на новый адрес.

- Все запросы со старого домена будут перенаправляться с кодом 301 на новый домен.

- Поисковые системы скорректируют ссылки на страницы в индексе на новый домен.

Плюсы:

- Пользователи и поисковики безболезненно переходят на новый домен.

- Простота настройки редиректа на DNS или веб-сервере.

- Возврат прежних позиций в течение недели.

Минусы:

- Небольшое временное падение позиций до обновления индекса поисковиками.

- Затраты на новый домен и миграцию контента.

- Необходимость обновить домен во всех каталогах и справочниках.

- Помощь временная.

Чтобы выбрать оптимальное решение для защиты от ботов, нужно учитывать особенности конкретного сайта. Главное — своевременно заметить накрутку и принять меры.

Чего не стоит делать

Вот самые неэффективные методы борьбы с накруткой:

1. Позитивная накрутка своего сайта.

Это не сработает, если ресурс уже пострадал от негативной накрутки. Потребуется многократно больше усилий, чтобы компенсировать ущерб. К тому же резкий рост посещаемости вызовет еще большее недоверие поисковиков.

2. Фильтрация трафика по странам или другим параметрам.

Накрутчики могут заранее вычислить целевую аудиторию сайта и настроить ботов под нее. Тогда фильтры заблокируют и реальных пользователей.

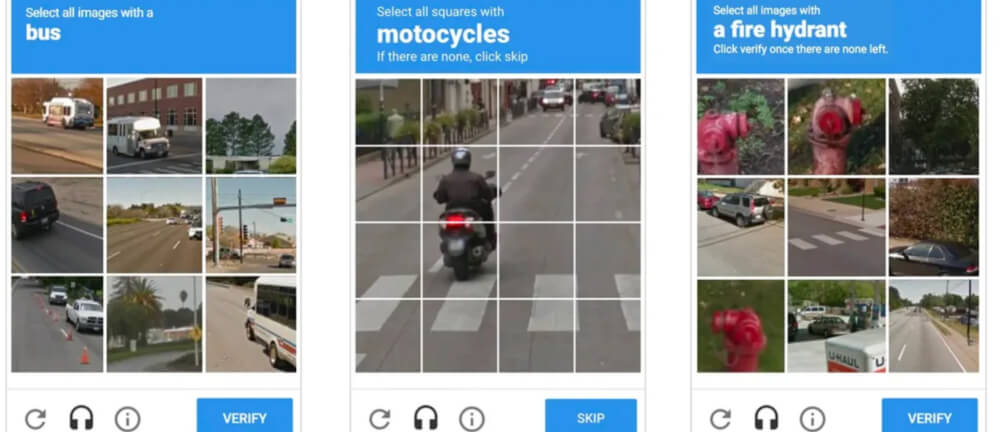

3. Установка сложной капчи.

Капча может отпугнуть реальных пользователей и сильно снизить конверсию сайта. Людям проще уйти на другой ресурс, чем вводить сложные коды.

Но есть исключение. Например, капча от Google ничего не просит вводить. Пользователю нужно выполнить простые действия:

- Поставить галочку «я не робот» (иногда этого достаточно, чтобы открылся сайт):

- Выбрать картинки, которые попросит Google. Например:

Сайт откроется, если пользователь верно выбрал изображения.

В целом, эти методы либо не работают, либо вредят сайту. Лучше использовать комплексный подход к борьбе с накруткой, чтобы избежать негативных последствий.

Кейс SEO.RU: как мы спасли сайт от накрутки ПФ

В апреле этого года мы выводили сайт строительной тематики из-под накрутки поведенческих.

Ситуация была такая:

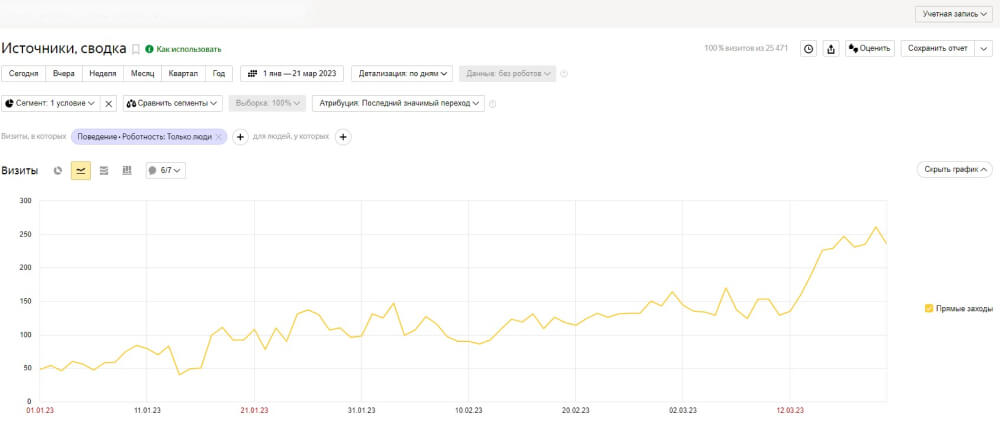

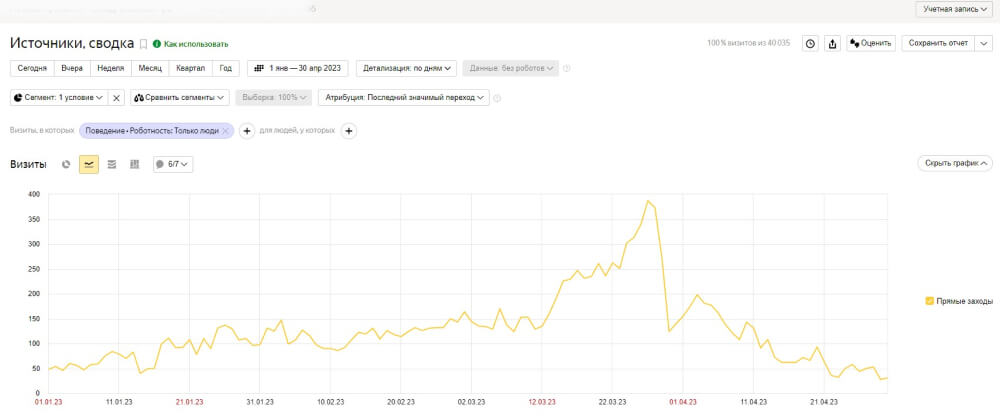

По отчетам в Метрике мы заметили аномальный всплеск прямых заходов на сайт:

Но трафик был некачественный — посетители проводили на сайте несколько секунд и уходили. Отсюда вырос процент отказов.

На графике виден всплеск отказов в тот же период, когда пришло много прямых заходов:

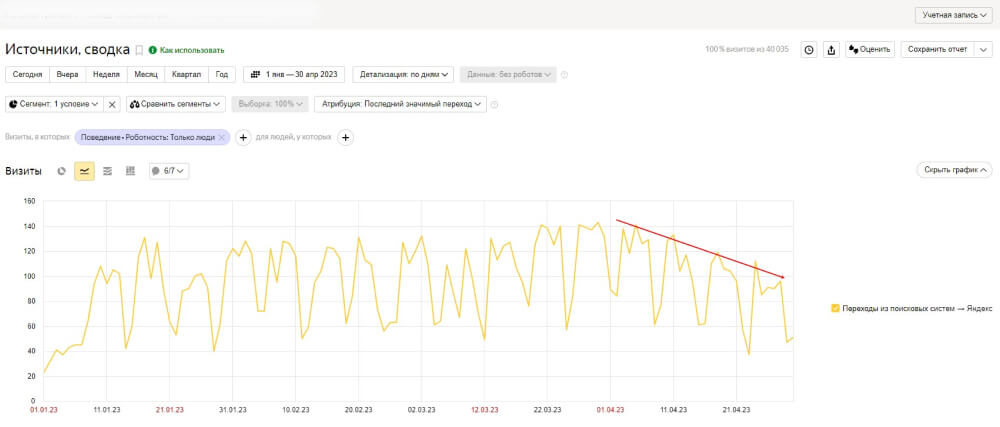

Позиции сайта начали снижаться. На графике видно снижение трафика по ПС в сравнении с ростом прямых заходов:

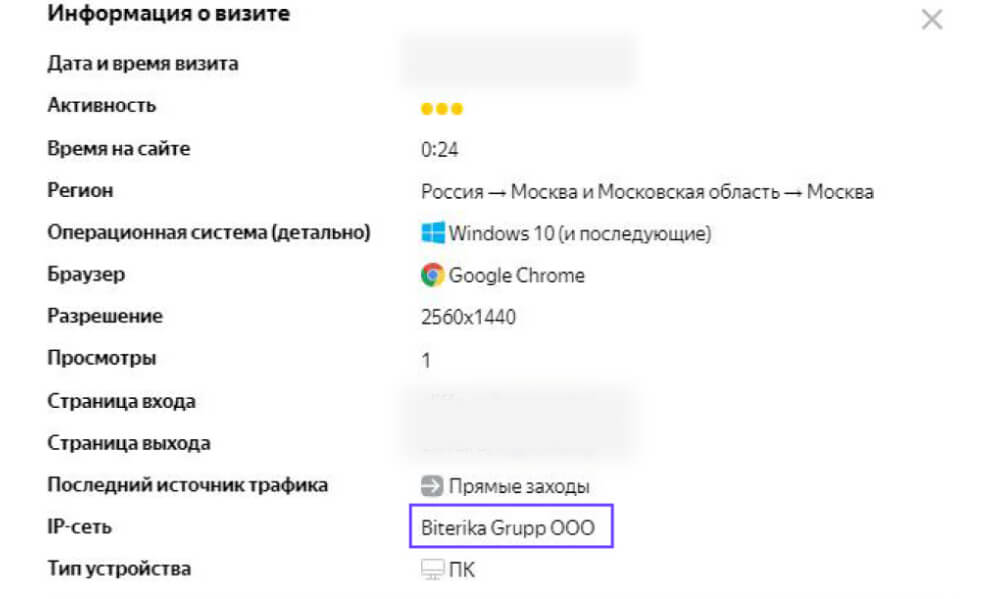

Из Вебвизора узнал, что боты заходят с серверов Biterika.

Если перейти в информацию о визите, можно увидеть с какой IP-сети заходил посетитель. В нашем случае было много визитов с сети Biterika Grupp OOO:

Эти боты умеют притворяться обычными пользователями. В Вебвизоре, можно увидеть, что они обычно проводят на сайте не более 2 минут, посещая 1-2 страницы. Они прокручивают контент с однородной скоростью и кликают, иногда даже в пустые области страницы. Их разрешение экрана может быть необычным, например, 600x200 или стандартным — 2560x1440.

В результате боты Biterika могут создать много проблем для сайта: испортить ПФ, повысить нагрузку на сервер и ухудшить позиции в поисковой выдаче.

Как мы боролись с ботами Biterika:

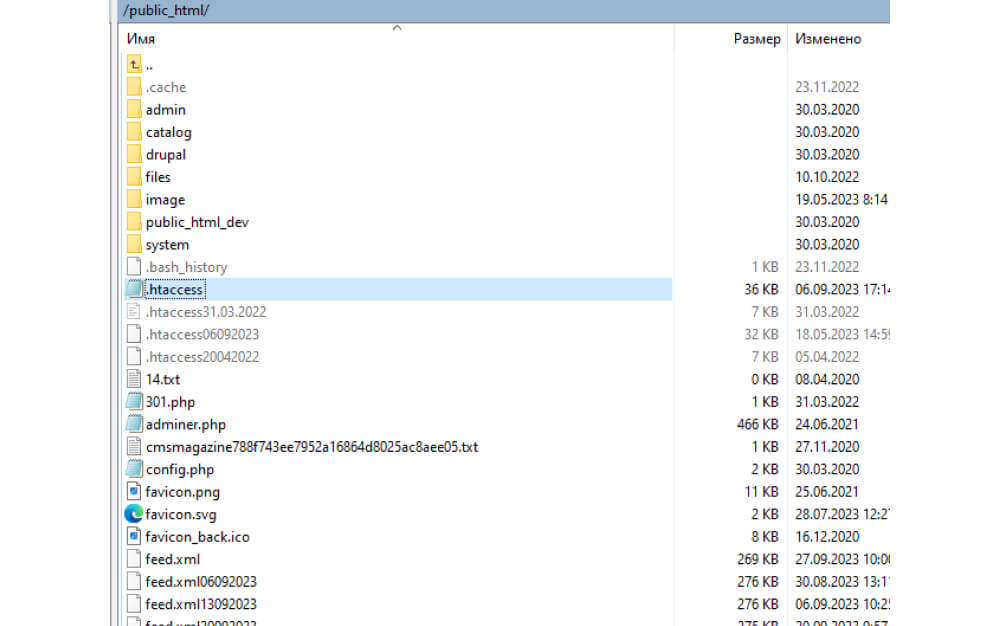

- Заблокировали ботов/парсеров через .htaccess

Для этого использовали файл .htaccess:

- Заблокировали IP-адреса с прокси-сервера Biterika.

Тут также использовали файл .htaccess для добавления IP-адресов с сервера Biterika в черный список.

Вот как это сделать:

- Заходим в FTP сайта.

- Находим файл .htaccess:

- Открываем его и загружаем туда IP-адреса ботов, которые собрали предварительно:

- И также загружаем User Agent ботов:

- Сохраняем изменения. Готово.

В итоге мы заблокировали вредоносные прямые переходы ботов Biterika.

Результат — снизилось количество посещений по прямым заходам:

Также снизилось количество отказов по ним:

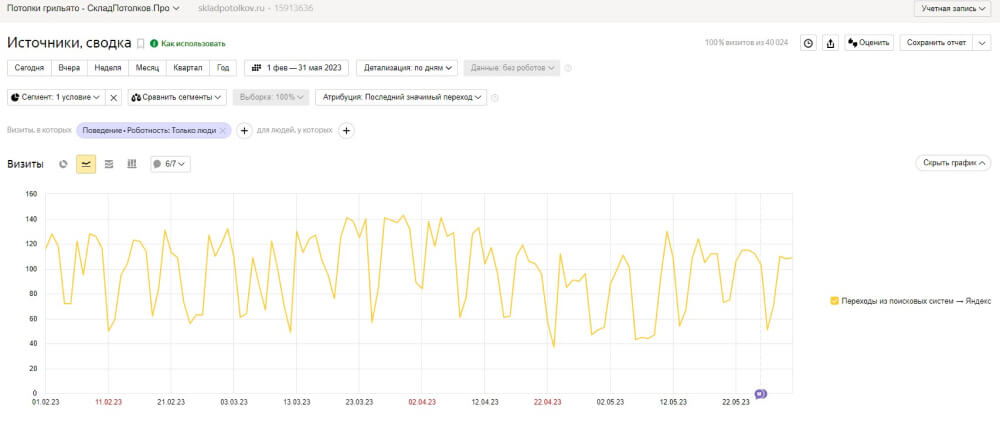

Начал снова расти трафик из поисковых систем:

Коротко: как можно бороться с накруткой ПФ ботами

- Накрутка поведенческих факторов может использоваться не только для продвижения своего сайта. Она также применяется, чтобы навредить конкурентам.

В этом случае на сайт конкурента накручивается искусственный трафик, который сразу уходит с сайта. Получается много коротких посещений.

Из-за этого у сайта конкурента растет показатель «Отказы» в статистике. А для поисковиков это значит, что сайт некачественный и его нужно понизить выдаче.

- Накрутки делятся на два вида: нативные — реальными людьми и RPA — программами-роботами.

- Обнаружить накрутку можно по данным в Яндекс.Метрике и Вебмастере по статистике за неделю.

- Если вашему сайту накручивают ПФ ботами можно:

- Заблокировать IP-адреса сервера, откуда идут боты.

- Установить антибот.

- Заблокировать ботов с помощью htaccess.

- Использовать сервис Cloudflare.

- Перенести сайт на новый домен с редиректом.

- Чего лучше не делать при борьбе с накруткой:

- Заниматься позитивной накруткой. Не компенсирует ущерб и вызывает недоверие поисковиков.

- Фильтровать трафик по странам или другим параметрам. Может блокировать реальных пользователей.

- Ставить на сайт сложную капчу. Снижает конверсию. Простые капчи, например, «я не робот», предпочтительнее.

Хотите узнавать больше про эффективное SEO-продвижение сайта? Подписывайтесь на наш канал в телеграме.