В обновленной справке Googlebot появилось указание размера файла, который сканируют боты: «Googlebot сканирует первые 15 МБ HTML-файла или поддерживаемого текстового файла. Все ресурсы, ссылки на которые указаны в HTML (изображения, видео, CSS и JavaScript), извлекаются отдельно. После первых 15 МБ файла Googlebot прекращает сканирование и рассматривает для индексации только первые 15 МБ файла. Ограничение размера файла применяется к несжатым данным. У других краулеров могут быть другие ограничения».

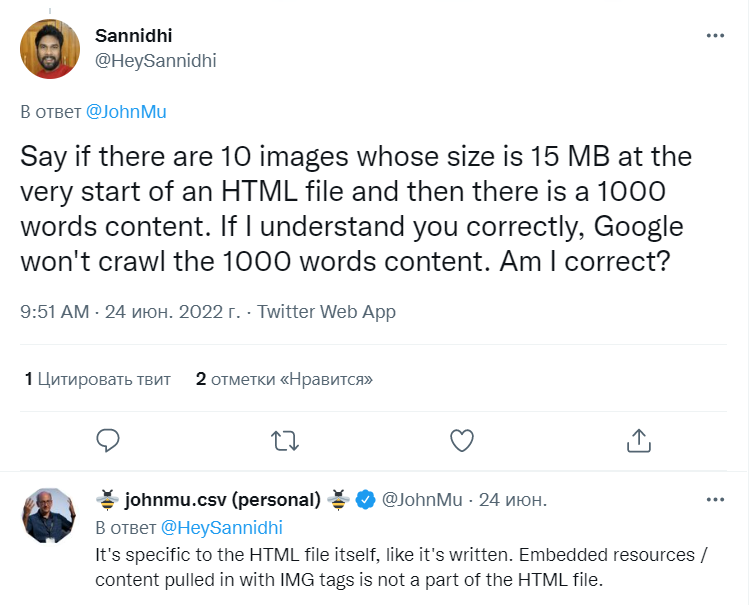

Джон Мюллер, сотрудник Поиска Google, отвечая на вопрос SEO-специалиста Саннидхи (Sannidhi) в Твиттере, пояснил, что лимит накладывается только на HTML-файл, а встроенные элементы не являются его частью:

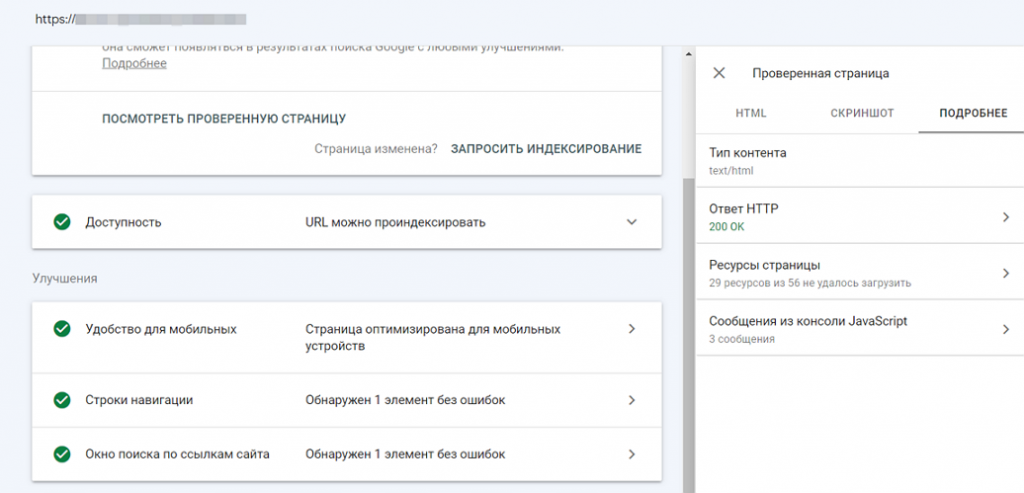

Проверить, какую часть контента сканирует и ранжирует бот Гугл, можно с помощью инструмента проверки URL-адресов в Google Search Console.

«Поработав с большим количеством различных сайтов могу отметить, что средний размер HTML-документа редко превышает 2-3 МБ, поэтому беспокоиться насчет данного нововведения не стоит. В то же время, SEO-специалисты должны знать эту особенность работы поискового робота Google и проверять размер HTML-страниц у всех новых сайтов. Сделать это можно с помощью Screaming Frog SEO Spider или любого другого робота-парсера».

Главный технолог SEO-эксперт компании SEO.RU

Полина Маенкова