Директива Crawl-delay задает ограничение на скорость обхода страниц сайта и используется, когда нужно задать поисковому роботу минимальный период времени (в секундах) между окончанием загрузки одной страницы и началом загрузки следующей. Такое ограничение скорости обхода снижало нагрузку на сервер и снимало риски сбоев в работе сайта при его обходе поисковыми ботами.

Но большинство серверов теперь динамичные и в разные периоды времени могут отдавать разную скорость ответа, что делает директиву Craw-delay бесполезной.

Google уже давно перестал учитывать директиву Crawl-delay, и обход роботы заканчивают автоматически, если фиксируют ошибку или замедление реакции сервера.

Теперь и Яндекс перестал учитывать Crawl-delay:

Проанализировав письма за последние два года в нашу поддержку по вопросам индексирования, мы выяснили, что одной из основных причин медленного скачивания документов является неправильно настроенная директива Crawl-delay в robots.txt […] Для того чтобы владельцам сайтов не пришлось больше об этом беспокоиться и чтобы все действительно нужные страницы сайтов появлялись и обновлялись в поиске быстро, мы решили отказаться от учёта директивы Crawl-delay.

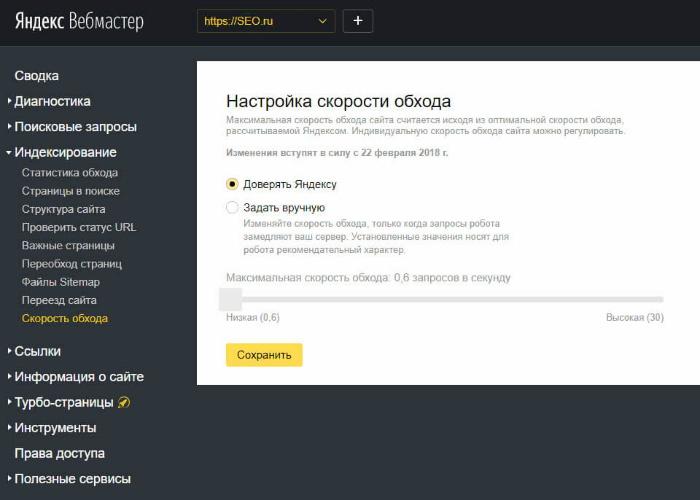

А чтобы сохранить возможность задавать ограничение скорости обхода страниц, разработчики добавили в Яндекс.Вебмастер новый инструмент «Скорость обхода» в раздел «Индексирование».

По умолчанию в инструменте «Скорость обхода» установлено значение «Доверять Яндексу», при котором скорость рассчитывается автоматически, исходя из опыта обхода сайта: поисковый бот учитывает при обходе допустимые нагрузки для вашего сервера.

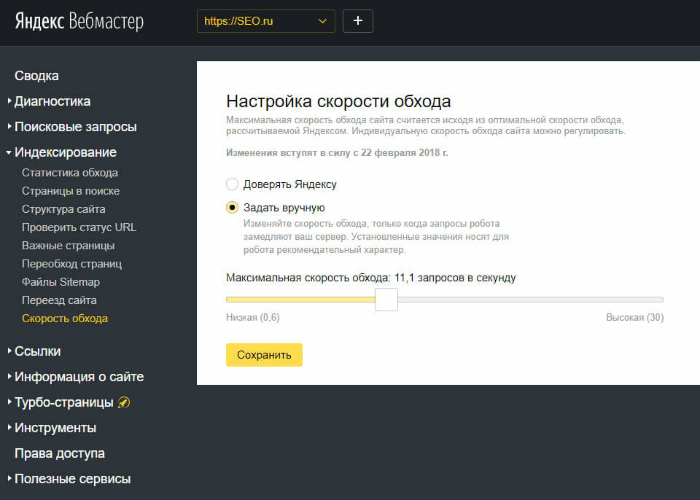

Если же вы заметите, что запросы робота замедляют ваш сервер, вы можете задать максимальную скорость обхода с точностью до десятых долей запросов в секунду.

Комментарий SEO-эксперта:

«Раньше директива Crawl-delay играла роль для SEO, но уже сейчас ее можно смело удалять из robots.txt у своих сайтов. По словам Яндекса, эта строчка уже не учитывается роботом, что делает ее присутствие в файле бесполезной. Сам инструмент можно проверить в вебмастере, однако внесенные изменения в сканировании будут применены только после 22 февраля, поэтому до этого времени, скорее всего, все сайты будут сканироваться по настройке «Доверять Яндексу». К слову, Google уже давно не учитывает эту директиву при обходе сайта и автоматически настраивает скорость сканирования в зависимости от скорости ответа сервера, на котором размещён сайт».

Технолог SEO-эксперт компании SEO.RU

Константин Абдуллин