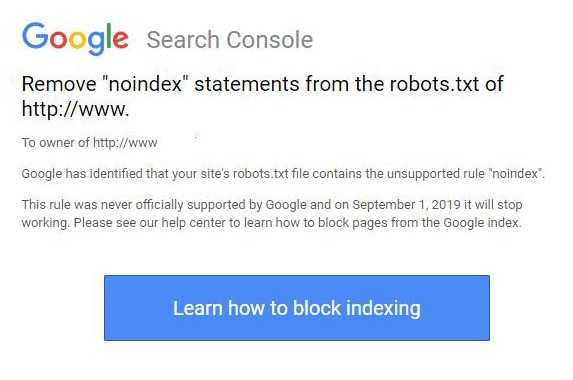

Западные SEO-специалисты стали получать письма от Google Search Console с напоминанием удалить тег noindex из файла robots.txt. Об этом сообщает издание Search Engine Roundtable.

Источник изображения: seroundtable.com

В письме владельцу сайта сообщается, что в файле robots.txt его сайта содержится запрещенный тег noindex. Google не поддерживал использование этого тега, а с 1 сентября 2019 это правило и вовсе перестанет работать.

Некоторые веб-мастера получили уведомление несмотря на то, что удалили все теги noindex еще несколько недель назад.

Комментарий SEO-эксперта:

«В практике нашей компании тег noindex никогда не использовался в файлах robots.txt, а применялся в коде страниц для исключения из индексирования и имел такой вид :<meta name="robots" content="noindex">.

Но этот тег уже устарел и на практике давно не используется, так как в последнее время работал 50/50. Веб-мастерам, использующим каким-либо образом тег noindex в robots.txt, рекомендуется прислушаться к сообщениям Google и устранить устаревшее правило.

Технически файл robots.txt «показывает» роботу-пауку, что сканировать, а что нет. При этом все же есть вероятность попадания закрытых страниц в индекс поисковых систем.

Вспомним, какие директивы используются в файле robots.txt:

- User-agent*: указывает, для какого поискового робота перечислены правила;

- Allow: разрешает обходить и индексировать указанную директорию;

- Disallow: запрещает обходить и индексировать указанную директорию;

- Sitemap: указывает местонахождение файла sitemap.xml;

- Clean-param: означает, что URL содержит параметры и индексировать их не нужно;

- Crawl-delay: устанавливает скорость в секундах, с которой робот должен сканировать каждую страницу».

Владимир Суматохин,

технолог SEO-эксперт компании SEO.RU