Эффективное продвижение сайта невозможно без совершенствования его технических параметров, в том числе файла robots. Robots.txt — это текстовый файл, находящийся в корневом каталоге сайта. Он состоит из набора инструкций для индексирования и сканирования файлов, страниц и каталогов сайта для поисковых машин.

Сразу оговоримся, что присутствие файла robots.txt на сервере обязательно. Даже если вы полностью открываете ресурс для индексации.

Индексация robots.txt

Первое, что индексируют и сканируют поисковые системы на ресурсе, — файл robots.txt. Есть условия действительности файла:

- Название. Исключительно robots.txt. Помните, что URL-адреса чувствительны к регистру.

- Местоположение. Файл должен находиться в корневом каталоге верхнего уровня хоста и быть единственным.

- Протокол. Поддерживаются все протоколы на основе URI — HTTP и HTTPS. Поисковые боты делают обычный GET-запрос, на который должен поступить ответ со статусом 200 OK. Возможна обработка файла с FTP-серверов: доступ осуществляется с использованием анонимного входа.

- Формат. Файл должен быть в текстовом формате. Его можно создать в любом текстовом редакторе с поддержкой кодировки UTF-8. Не рекомендуем использовать текстовые процессоры, так как они могут сохранять файлы в проприетарном формате и добавлять дополнительные символы, не распознаваемые поисковыми роботами.

- Размер. Для Google значение не должно превышать 500 килобайт, а для Яндекса — 32 КБ. Гугл переходит к файлу, но сканирует первые 500 килобайт, а Яндекс сразу смотрит на размер и, если лимит превышен, считает, что доступ к содержимому сайта закрыт. При успешном сканировании и индексировании файла Яндекс исполняет инструкции в течение 2 недель, а для Google они являются рекомендуемыми и не обязательны к исполнению.

Настройка robots.txt

Чтобы правильно заполнить robots.txt, в первую очередь нужно придерживаться правил, заданных поисковиками. Особенно это касается директив.

Директивы

Поисковые роботы Google, Яндекс. Bing, Yahoo и Ask поддерживают следующие директивы:

| Директива | Описание |

|---|---|

|

User-agent |

Обязательная директива. Указывает на поискового робота, которому адресованы правила. Учитывается название бота или *, которая адресует правила ко всем ботам. Наиболее популярные в России:

Рекомендуем периодически просматривать логи сайта и закрыть доступ для агрессивных ботов, которых развелось очень много. |

|

Allow и Disallow |

Разрешает и запрещает индексирование и сканирование отдельных файлов, страниц и каталогов ресурса. Если не указан запрет, то по умолчанию сканирование разрешено. Используйте запрет для:

Их можно использовать совместно в одном блоке. Приоритет отдается более длинному правилу. Если префиксы одинаковой длины, то при конфликте приоритет отдается Allow. |

|

Sitemap |

Указывает путь к одноименному файлу. |

|

Clean-param |

Указывает параметры страницы, которые не нужно учитывать. Существует два типа параметров URL:

Не стоит очищать параметры, влияющие на контент, поскольку их можно использовать как точку входа при SEO-продвижении. |

|

Crawl-delay |

Указывает время в секундах, через которое необходимо приступить к загрузке следующей страницы. |

|

Host |

Указывает на домен с протоколом и портами. Указывайте нужный протокол – HTTP или HTTPS. Если порт не отличается от стандартного, то его не нужно указывать. Отметим, что Яндекс отказался от этой директивы и заменил ее 301 редиректом. Однако веб-мастера не торопятся удалять Host из файла, поскольку работе поисковых роботов это не мешает. |

Синтаксис и примеры

Помимо директив, чтобы правильно настроить robots.txt, нужно соблюдать правила синтаксиса.

Разберем на примерах.

-

Указания чувствительны к регистру. Пример:

http://site-example.ru/file.htmlиhttp://site-example.ru/File.html— это разные пути.

-

Для кириллических адресов используйте Punycode.

#НЕВЕРНО

Disallow: /корзина#ВЕРНО:

Disallow: /%D0%BA%D0%BE%D1%80%D0%B7%D0%B8%D0%BD%D0%B0Для комментирования используйте #. Как в предыдущем пункте.

Хотя бы одна Allow или Disallow должна быть в группе. Пример:

#Блокировка доступа ко всему ресурсу определенному боту

User-agent: Googlebot

#Сюда указывается токен бота

Disallow: /

#Блокировка доступа ко всему ресурсу всем ботам

User-agent: * #Звездочка означает «любой бот»

Disallow: /

Обязательно указывайте Sitemap. Хоть эта директива необязательна, мы советуем ее указывать, поскольку адрес может отличаться от стандартного и боты могут ее не найти. Пример:

User-agent: *

Allow: /

Sitemap: https://site-example.ru/sitemap.xml

Для переноса строки используйте знак $.Пример:

User-agent: *

Disallow: https://site-example.ru/здесь-будет-очень-длинный- $

адрес-сайта

Sitemap: https://site-example.ru/sitemap.xml

Host: https://site-example.ru

Можно запретить доступ к отдельному файлу, странице или категории. Пример:

User-agent: *

Disallow: /page-example.html #Нужно указывать весь путь ресурса

Disallow: /images/image-example.png #Любой файл: картинка, документ, все что угодно

Disallow: /*.js$ #Запретить определенный тип файла

Disallow: /category-example/

Allow: /category-example/subcategory-example/ #Предыдущей строкой запретили раздел и его последующие подкатегории и файлы, но далее можно разрешить сканировать другой раздел

Не бойтесь совершить ошибку — файлы robots.txt можно проверить на валидность с помощью специальных сервисов.

Проверка robots.txt на валидность

Чтобы убедиться в правильности составления файла robots.txt воспользуйтесь инструментами проверки от поисковых систем:

- Проверка в Google Search Console. Нужно авторизоваться в аккаунте с подтвержденными правами на сайт. Далее перейти в «Сканирование», а затем в «Инструмент проверки файла robots.txt». Проверить можно только сайт, в котором вы авторизовались.

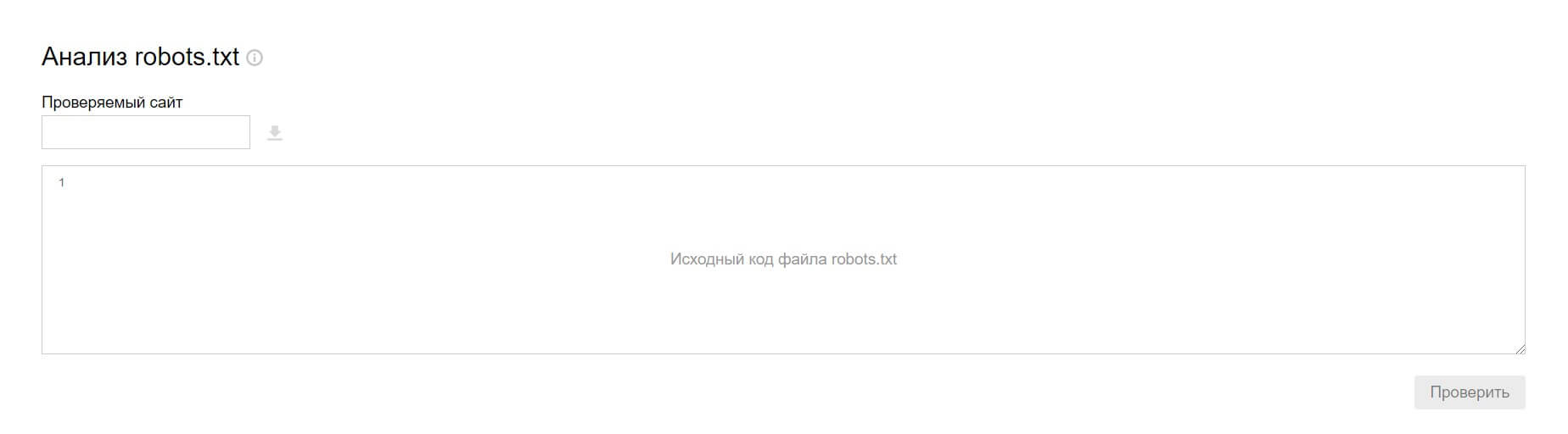

- Проверка в инструменте Яндекса. Авторизация не нужна, просто укажите адрес сайта или загрузите исходный код файла. Проверить можно любой сайт.

В сервисах проверки можно загрузить несколько страниц одновременно, увидеть все ошибки, исправить их прямо в инструменте и перенести готовый файл на сайт.