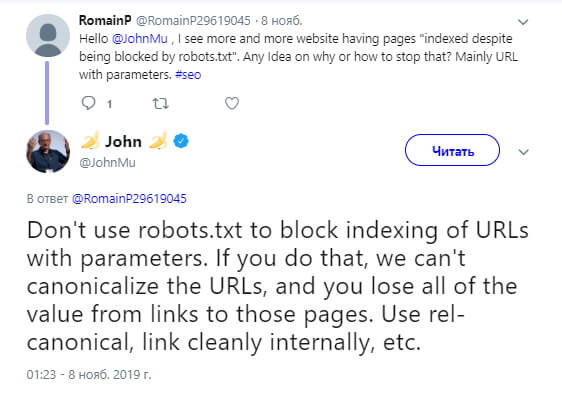

Специалист компании Google Джон Мюллер, отвечая на вопрос веб-мастера в Твиттере, сообщил, что не стоит использовать robots.txt, чтобы заблокировать индексацию URL с параметрами. Мюллер отмечает, что такой способ не позволит Google каноникализировать адрес, и в результате ссылки на эти страницы потеряют свою ценность.

В качестве альтернативного решения Мюллер предложил использовать rel=canonical либо размещать внутренние ссылки:

Комментарий SEO-эксперта:

«Действительно, тег rel=canonical — это хорошее решение в том случае, когда вы хотите закрыть от индексирования страницы пагинации и фильтры товарных категорий, но сохранить и передать вес на основные страницы. Такие технические страницы, как корзина, страница регистрации/логина и другие, лучше закрывать в файле robots.txt».

Технолог SEO-эксперт компании SEO.RU

Владимир Суматохин